|

|

| Appunti informatica |

|

|

|

| Appunti informatica |

|

| Visite: 1715 | Gradito: |

Leggi anche appunti:ArchivioARCHIVIO:è un insieme organizzato di informazioni caratterizzate da alcuni aspetti Modello a Scambio di Messaggi: Interazioni tra processiModello a Scambio di Messaggi: Interazioni tra processi Nel modello La porta parallelaLA PORTA PARALLELA La porta parallela (detta anche LPT) è un'interfaccia usata inizialmente |

|

|

Università degli studi di Salerno A.A. 2001/2002

Corso di Intelligenza Artificiale: Metodi e Tecniche

Storia e fondamenti dellfIntelligenza Artificiale

Talvolta, quando ci mettiamo di fronte ad un computer e lo osserviamo mentre esegue i suoi compiti, può accadere di avere lfimpressione che esso sia dotato di una specie di intelligenza. Tuttavia sappiamo che questa impressione è sbagliata. Un computer, infatti, non fa altro che eseguire una sequenza di istruzioni, esplicitate in un programma, in maniera meccanica. Di norma, col termine Intelligenza Artificiale, viene designata una disciplina scientifica (talvolta considerata una branca della più generale scienza dei calcolatori) il cui obiettivo può essere definito come lfindagine sui meccanismi soggiacenti alle facoltà cognitive degli esseri umani (come il linguaggio, il ragionamento, la capacità di risolvere problemi, la percezione) e la loro riproduzione mediante computer opportunamente programmati. Il primo ad usare lfespressione artificial intelligence per indicare questo genere di ricerche è stato John McCarty, durante uno storico convegno che si tenne nella città statunitense di Dartmouth nel 1956. Con il passare degli anni la disciplina designata come intelligenza artificiale ha subito una divisione in due aree, che si distinguono in relazione al senso del termine riproduzione che abbiamo usato nella precedente definizione. La prima area è la cosiddetta

· intelligenza artificiale forte, la quale ritiene che un computer opportunamente programmato possa veramente essere dotato di una genuina intelligenza, non distinguibile in nessun senso importante dallfintelligenza umana.

La seconda area, per contro, viene chiamata

· intelligenza artificiale debole che sostiene che un computer opportunamente programmato possa solamente simulare i processi cognitivi umani, o alcuni di essi, nello stesso senso in cui un computer può simulare il comportamento di un evento atmosferico, o di una fissione nucleare (nessuno direbbe che un computer che simula una tempesta è una tempesta!). In questo caso, dunque, lfaccento viene posto su ciò che un programma è in grado di fare, senza fare assunzioni sul fatto che il modo in cui lo fa coincida ad un qualche livello con i processi mentali umani.

Le due declinazioni dellfintelligenza artificiale, pur differenziandosi profondamente rispetto agli assunti filosofici di base e alle finalità, condividono metodologie, strumentazioni e tecnologie. In particolare entrambe sostengono che per riprodurre e/o simulare un comportamento intelligente al computer sia necessario elaborare informazione (rappresentata da simboli discreti) mediante un programma. In questo senso esse costituiscono quella che viene chiamata intelligenza artificiale classica. La prima formulazione esplicita del fondamento teorico dellfintelligenza artificiale si può forse rintracciare nel filosofo empirista inglese Thomas Hobbes (vissuto nel 600), scrisse:

gRagionare non è nientfaltro che calcolare.h

Questa frase consente di comprendere meglio la suddivisione che è stata effettuata dei fondamenti nelle discipline seguenti:

Il concetto di intelligenza non è mai stato ben definito. La maggior parte dei tentativi per chiarirlo usano espressioni a loro volta imprecise ed ambigue. Molti non ritengono di poter attribuire il predicato intelligente ad alcuna macchina e limitano tale proprietà, per lo più per definizione, solo allfuomo. Più utile è la seguente definizione: lfintelligenza è la facoltà di adattarsi ad un mondo che cambia. Quanto più questa facoltà di adattamento è spiccata e molteplice, tanto più il sistema è intelligente. Secondo questa definizione sono intelligenti non solo gli uomini, ma tutti gli esseri viventi ed anche alcune macchine. I sistemi di intelligenza artificiale vengono spesso messi a confronto con le facoltà intellettuali dellfuomo. Così i critici giungono soddisfatti alla conclusione che il computer è una macchina stupida che sa calcolare in modo eccezionalmente veloce, incapace però di creare o realizzare alcunché. Quando si verifica il contrario si pongono allora nuove mete e quelle raggiunte non vengono più considerate. Così si era affermato che il computer non avrebbe mai imparato a giocare decentemente a scacchi. Invece lf ha fatto, si dice allora che non saprà mai comporre una sinfonia. Se poi ciò un giorno accadesse, si pretenderà che sappia ridere ad una battutac

Il termine Artificial Intelligence (Intelligenza Artificiale) fu coniato durante un seminario tenutosi al Darthmouth College (New Hampshire, USA) nellfestate del 1956. I fondatori della nuova disciplina, John McCarty, Marvir Mirsky, Allan Newell, Herbert Simon e Claude Shannon (uno dei padri della cibernetica), si ponevano come obiettivo quello di far svolgere alle macchine compiti diversi dalla pura e semplice computazione. Cose come il riconoscimento della voce, la comprensione del linguaggio naturale, lfidentificazione degli oggetti, il ragionamento deduttivo. Essi profetizzavano che macchine general purpose (di uso generale) come i computer avrebbero scoperto teoremi matematici, composto musica, vinto il campionato mondiale di scacchi. Fu così adottata la seguente definizione:

Intelligenza artificiale è una disciplina che studia la possibilità di ottenere dalle macchine prestazioni che, se compiute da essere umano, sarebbero definite più intelligenti.

Unfaltra definizione comunemente accettata è la seguente:

Lfintelligenza artificiale è quella disciplina, appartenente allfinformatica, che studia i fondamenti teorici, le metodologie e le tecniche che permettono di progettare sistemi digitali (hardware) e sistemi di programmi (software) capaci di fornire allfelaboratore elettronico delle prestazioni che, ad un osservatore comune, sembrerebbero essere di pertinenza esclusiva dellfintelligenza umana.

Lfassunto principale è che lfunica forma di intelligenza possibile sia quella umana, e ciò è molto parziale. Ef invece sfacciatamente antropocentrica lfidea che ci si debba basare sullfintelligenza umana per misurare lfintelligenza delle macchine. Infatti potrebbero esistere – e sicuramente esistono – altre forme dfintelligenza, come lfintelligenza animale e lfintelligenza aliena (di esseri non appartenenti alla Terra), tutte rientranti in una definizione generale che bisogna ancora trovare. Forse è proprio a causa di concetti così approssimativi che il bilancio della disciplina chiamata Intelligenza Artificiale risulta in passivo, nonostante il successo di numerose applicazioni, in primis i cosiddetti export-systems (sistemi esperti): programmi che tentano di emulare, riuscendovi spesso molto bene, il comportamento di un esperto umano (medico, geologo, tecnico di manutenzione, ecc.). Forse è proprio a causa di definizioni così approssimative che gli studiosi della materia sono ritenuti di serie B. Per esempio tutti apprezzano i programmi giocatori di scacchi, ma nessuno accetta di attribuire ad essi vera intelligenza. Eppure il più forte giocatore di scacchi del momento, Garry Gasparov, arriva ad affermare:

gEf la prima volta che mi capita di giocare non tanto con un computer, ma con qualcosa che possiede una certa forma dfintelligenzac Se vai a minacciare la macchina, quella contrattacca. Ma se non le crei pericoli immediati si concentra sui suoi calcoli, si apre e ti offre una chanceh.

Si riferisce alla strategia con cui era riuscito ad ottenere una rivincita (dopo una clamorosa sconfitta) su Deep Blue, un computer Ibm da 200 milioni di mosse al secondo. La verità è che non si può parlare di intelligenza delle macchine se prima non si definisce il concetto generale di intelligenza, ma questa è una cosa piuttosto difficile. A fare un pof di chiarezza ci hanno provato in molti, dal matematico Alan Turing al fisico Roger Penrose, uno degli ultimi, in ordine di tempo, a dire la sua sullfargomento.

Il campo dellfintelligenza artificiale può dividersi nei seguenti settori principali:

L'intelligenza artificiale, prima di trasformarsi in una impresa tecnologica, affonda le proprie radici in un complesso sistema filosofico incentrato sulle relazioni logico-matematiche.

Pascal per primo progettò una macchina calcolatrice adibita allo svolgimento delle operazioni più elementari. Questa semplicità manifestata in addizioni e sottrazioni celava il proposito di opporre l'esprit de géometrie (la ragione scientifica) a l'esprit de finesse (il sentimento) dimostramdo così che l'aspetto del primo può venir eseguito macchinalmente, mentre il secondo solamente è in grado di coglierne l'essenza. Siamo nel 1650.

Liebniz più tardi elaborò una teoria secondo la quale una macchina, attraverso una serie di proposizioni concatenate, potesse effettuare deduzioni; il pensiero è dunque riconducibile ad un calcolo, l'algebra è la chiave interpretativa della logica.

Nel diciannovesimo secolo Babbage e Boole, entrambi inglesi, approfondirono le intuizioni dei loro precedenti elaborando i principi fondamentali sui quali si basano tuttora i moderni elaboratori.

Boole, seguendo le intuizioni liebniziane, concepì un formalismo algebrico in grado di rappresentare le figure della logica, rifacendosi al ragionamento elaborato da Aristotele: il sillogismo(ragionamento deduttivo che ricava tutte le verità da principi universalissimi e intuitivi).Esaminando il formalismo di Boole si nota che ogni termine è rappresentato da un simbolo che prende valore 1 o 0 a seconda che sia vero o falso. Boole riconduceva la logica ad un semplice calcolo.

Shannon dimostrò che la logica simbolica di Boole, così come si applicava alla rappresentazione di Vero e Falso, poteva essere usata per rappresentare le funzioni degli interruttori nei circuiti elettronici. Ciò divenne la base della progettazione dell'elettronica digitale, con applicazioni pratiche nella commutazione telefonica e nell'ingegneria dei computer. Diversi pensatori hanno ipotizzato che la nostra mente impieghi effettivamente la logica matematica, ovvero che le leggi della logica dei predicati siano davvero le leggi del pensiero.

Gottlob Frege lanciò il programma 'logistico' che riduceva la matematica ad un ramo della logica.Egli riteneva che i concetti matematici si potevano ottenere da quelli logici. Il principale esponente della formulazione matematica è David Hilbert.

Hilbert si occupa sostanzialmente di pure ricerche matematiche, di cui fanno parte anche le ricerche sui fondamenti della geometria, ma i suoi vasti interessi sono guidati da una visione unificatrice e dalla consapevolezza del ruolo che la matematica ha nel quadro delle scienze in generale. Nella sua opera Fondamenti della geometria, gli assiomi che Hilbert pone alla base del suo sistema non esprimono nessun contenuto che non sia quello dato dalle loro relazioni puramente logiche. A questo proposito viene attaccato da Frege, che non può accettare il fatto che gli assiomi diventino definizioni implicite di concetti come punto, retta, piano. Inoltre per Frege gli assiomi sono proposizioni vere che non vengono dimostrate perché la loro veridicità nasce da una intuizione spaziale, mentre per Hilbert gse assiomi arbitrariamente stabiliti non sono in contraddizione, allora essi sono veri ed esistono gli enti definiti tramite quegli assiomih e vengono scelti secondo criteri di non contradditorietà, completezza e indipendenza. Al fondo cfè la convinzione, espressa al congresso internazionale di filosofia e matematica di Parigi del 1900, che ogni problema ammette soluzione. La convinzione di Hilbert trova però un grosso ostacolo nei risultati scoperti da Godel nel 1931 che dimostra lfimpossibilità di dimostrare, nellfambito della matematica finitista, la coerenza di teorie come lfaritmetica,

lfanalisi o la teoria degli insiemi.

Gödel, con il suo Teorema dell'incompletezza, ha provato che non è possibile avere assiomi sufficienti per dimostrare tutto, ossia dato qualsiasi sistema formale, è possibile arrivare a proposizioni che siano contemporaneamente vere e non vere, ovvero indecidibili. Godel ha dimostrato, in pratica, che la logica ha un limite come strumento per conoscere l'universo: in nessun sistema e' possibile definire il concetto di verita'(ovvero definire tutte le proposizioni che sono vere in tale sistema).

Roger Penrose afferma che quando il teorema di Godel viene usato gcome argomento contro la possibilità di costruire macchine pensanti esso suggerisce che vi siano davvero dei limiti al potere razionale della mente umanah. D'altra parte, lo stesso Godel aveva fatto allusione a possibili interpretazioni di questo tipo, quando aveva affermato che glo spirito umano non è capace di formulare (o meccanizzare) tutte le proprie intuizioni matematicheh. Gödel però non riteneva affatto che il suo teorema escludesse uno sviluppo dell'Intelligenza Artificiale. Affermava, infatti: gResta la possibilità che esista (e possa persino essere scoperta empiricamente) una macchina dimostrativa che di fatto è equivalente all'intuizione matematica (alla mente umana), anche se non è possibile dimostrarlo, né è possibile dimostrare che essa fornisce solo teoremi corretti della teoria dei numerih.

Il teorema di Godel non dimostra l'impossibilita' di costruire una macchina intelligente: dimostra una limitazione intrinseca di qualsiasi forma di intelligenza. Il lavoro di Gödel è strettamente intrecciato a quello di Alan Turing.

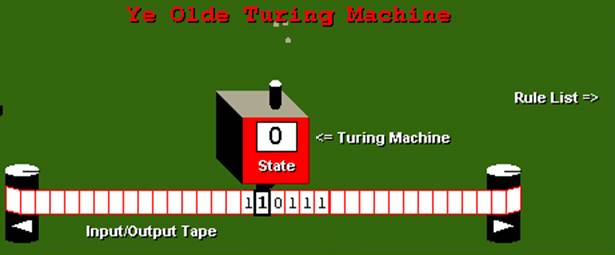

Turing trasportò infatti sul computer i risultati di Gödel e dimostrò che è impossibile costruire un computer che stabilisca la verità o la falsità di tutte le proposizioni matematiche. Data una congettura non possiamo essere sicuri che esista un programma in grado di verificarla in un numero finito di passi. Non è possibile stabilire a priori se un dato programma è in grado di completare in un tempo finito il suo compito. Fu in tal modo, infatti, che Turing pervenne a una delle invenzioni fondamentali del nostro secolo introducendo un modello astratto di macchina calcolatrice programmabile, oggi chiamata appunto macchina di Turing. Una gmacchina di Turingh e' una macchina in grado di compiere le operazioni che servono per operare con la logica matematica: leggere i simboli di un'espressione, elaborare i simboli, scrivere nuovi simboli, passare ad esaminare nuovi simboli. A seconda del simbolo che legge e dello stato in cui si trova, la macchina di Turing decide se spostarsi avanti, indietro, scrivere un simbolo, cambiare stato o fermarsi. La macchina di Turing e' un sistema formale: un sistema per manipolare automaticamente un alfabeto di simboli secondo un insieme finito di regole.

Turing e Church pervennero alla conclusione che la classe delle funzioni effettivamente computabili (calcolabili mediante un algoritmo) coincide con quella delle funzioni calcolabili da una M.d.T (o equivalentemente Turing-computabili), e che la classe delle funzioni effettivamente computabili equivale a quella delle funzioni ricorsive. (Tesi di Churc-Turing).

Figura - La macchina di Turing simulata

Si parla di 'tesi' e non di 'teorema' dal momento che non c'è alcuna dimostrazione della sua validità. Tutti i moderni calcolatori sono equivalenti ad un macchina di Turing, nel senso che un computer può fare tutto quello che una macchina di Turing può fare. Se ipotizziamo che i processi che avvengono nella nostra testa quando pensiamo, ragioniamo, parliamo e capiamo possono essere descritti come sistemi formali, potremmo concludere che anche il cervello è una specie di macchina equivalente a una macchina di Turing e quindi a un computer. Questo non vuol dire che nel nostro cervello ci deve essere una testina che scrive simboli su un nastro infinito. Stiamo soltanto dicendo che - se partiamo da questa prospettiva - le operazioni che avvengono nel nostro cervello quando pensiamo sono manipolazioni di simboli, fisicamente rappresentati, secondo regole; detto in altri termini, sono una specie di programmi. Questa teoria sulla natura del pensiero viene comunemente indicata come teoria rappresentazionale della mente, e costituisce uno dei fondamenti teorici di molta parte dell'intelligenza artificiale. Infatti, se la suddetta teoria è vera, il problema di riprodurre su un computer le capacità cognitive degli esseri umani si 'ridurrebbe' a quello di trovare le regole con cui il nostro cervello elabora i simboli mentali, e trasformarle in programmi. Alan Turing può sicuramente esser fregiato del titolo di padre dell'intelligenza artificiale. In un articolo del 1950 intitolato gMacchine Calcolatrici e Intelligenzah, il grande scienziato inglese inizia proprio con questa frase: gMi propongo di considerare la domanda: Possono le macchine pensare?h. Dopo avere espresso la sua scarsa fiducia nei tentativi di definizione astratti, egli propone un metodo per rispondere al quesito che si basa su una specie di gioco, il gioco dell'imitazione.Si tratta di un gioco a cui partecipano tre persone tra loro estranee. Due di loro, di sesso opposto, sono i candidati; il terzo (di cui è indifferente il sesso) è l'interrogante. L'interrogante viene chiuso in una stanza in modo che non abbia alcun contatto, di nessun tipo, con gli altri. Lo scopo del gioco per l'interrogante è capire quale dei due candidati sia l'uomo e quale la donna; egli può solo fare delle domande ai candidati mediante una telescrivente (oggi useremmo un computer collegato in rete). Questo vincolo è ovviamente dettato dalla necessità di evitare che l'aspetto, la voce, o persino la calligrafia dei candidati possano influenzare il giudizio. ). Scopo dei candidati è ingannare l'interrogante. Ora, dice Turing, immaginiamo di mettere al posto di uno dei due candidati una macchina 'presunta intelligente'. Se l'interrogante non è in grado di capire quale tra i suoi interlocutori sia un uomo e quale una macchina, allora possiamo asserire tranquillamente che la macchina è intelligente. È importante che le domande dell'interrogante durante il gioco riguardino vari argomenti e abbiano un carattere generale. Infatti se chiedessimo gquanto fa 10 elevato alla 27 diviso 4 h pensando che la macchina risponderebbe subito mentre l'uomo (o la donna) impiegherebbe molto più tempo, potremmo essere tratti in inganno da un trucco banale: basterebbe programmare il computer per aspettare alcuni minuti prima di rispondere a domande sui numeri. Mentre se una macchina fosse veramente in grado di superare il test rispondendo a domande sulla poesia, o sui suoi gusti gastronomici, o sull'amore, allora il successo ci dovrebbe far ammetter che essa sia intelligente.

Il gioco dell'imitazione nella versione con il giocatore artificiale è divenuto noto come test di Turing, e secondo il suoi ideatore sarebbe in grado di sostituire in tutto e per tutto la domanda astratta 'Possono pensare le macchine?'. Esso è cioè un test per l'intelligenza. Questa convinzione è stata sottoposta a diverse critiche. Ad esempio, quando nella metà degli anni '60 una grande quantità di persone furono tratte in inganno da un semplice programma - noto come Eliza - in grado di sostenere brevi e banali conversazioni in inglese, molti ritennero che si fosse confutata l'adeguatezza del test.

Tuttavia ancora oggi la maggior parte degli studiosi di intelligenza artificiale è propensa a credere cha il superamento del test di Turing, opportunamente condotto, costituisca, se non una prova definitiva, almeno un forte indizio dell'intelligenza di un computer.

La matematica, nello studio dellfintelligenza artificiale, ha dato il suo apporto anche con lo sviluppo del calcolo delle probabilità. Nella realizzazione di macchine intelligenti, mediante lfuso di sistemi basati sulla probabilità e sul caso, è possibile ricreare situazioni comportamentali abbastanza realistiche. Nel mondo che ci circonda troviamo una quantità innumerevole di situazioni probabilistiche. La probabilità nasce per rispondere ad alcune domande. Infatti nel lontano 1654 un giocatore d'azzardo,il cavaliere di Merè, chiese consiglio ad un matematico francese, Blaise Pascal, sul modo di ripartire le sue puntate in denaro in un gioco di dadi. Pascal discusse il problema con un altro eminente matematico, di nome Pierre de Fermat, e la soluzione di questo problema diede origine alla teoria della probabilità. Fino ad allora, infatti, ad opera principalmente di Galileo Galilei e Isaac Newton, dominava un modo di vedere la realtà, detto determinismo meccanicistico secondo il quale, ogni fenomeno fisico nel mondo reale doveva seguire leggi matematiche e che non ci si poteva fermare alla descrizione di come era fatto il mondo, ma si doveva capire anche come funzionava. Nasceva così la convinzione che poche leggi governavano i fenomeni del mondo fisico e permettevano di prevedere ogni evoluzione futura dell'universo. Ma per Pascal e Fermat il meccanicismo deterministico non riusciva a risolvere tutti i problemi che la ricerca poneva: certi fenomeni non si verificavano con certezza ma avevano una evoluzione casuale non univocamente prevedibile. La prima interpretazione del termine 'probabilità', che è stata formalizzata dal grande matematico francese Pierre Simon Laplace e che è conosciuta come impostazione classica.Oltre agli studi sulla probabilità Pascal ideò un calcolatore meccanico ad ingranaggi per eseguire addizioni e sottrazioni che rappresenta il vero punto di partenza che ha condotto ai moderni elaboratori. La cosiddetta 'pascalina' fu possibile perché si fusero due scienze: la matematica del calcolo e la tecnologia dell'orologio. La macchina si basava, come l'abaco, sul valore di posizione. Infatti essa era formata da una serie di ingranaggi dentati con sopra scritti i numeri da 0 a 9. Il primo ingranaggio indicava le unità; ad ogni suo giro completo corrispondeva lo spostamento di un numero del secondo, che indicava le decine, e così via, fino alle centinaia di migliaia (logica del 'riporto automatico'). Per farla funzionare bastava una manovella. Il suo limite stava nel fatto che permetteva solo addizioni e sottrazioni.

John von Neumann diede il suo apporto alla statistica e allfinformatica. Fu uno dei fondatori della teoria dei giochi. Il suo primo contributo fu il teorema minimax: esso stabilisce che in certi giochi a somma zero (in cui cioè la vincita di un giocatore è uguale e contraria alla perdita dellfaltro giocatore) e ad informazione perfetta (in cui cioè ogni giocatore conosce esattamente sia le strategie dellfaltro giocatore, che le loro conseguenze), esiste una strategia che permette ad entrambi i giocatori di minimizzare le loro massime perdite (da cui il nome minimax). Per ogni sua possibile strategia, un giocatore considera tutte le possibili strategie dellfavversario, e la massima perdita che potrebbe derivargli; egli gioca poi la strategia per cui tale perdita è minima. Tale strategia, che minimizza la massima perdita, è ottimale per entrambi i giocatori se essi hanno minimax uguali (in valore assoluto) e contrari (in segno): nel caso che tale valore comune sia zero, allora è inutile giocare. Inoltre von Neumann modificò il progetto del calcolatore in modo da permettere la memorizzazione interna del programma. La programmazione, che fino ad allora richiedeva una manipolazione diretta ed esterna dei collegamenti, diveniva la prima realizzazione della macchina universale inventata da Alan Turing nel 1936: in altre parole, un computer programmabile nel senso moderno del termine. AllfIstituto di Princeton egli si dedicò alla progettazione di un nuovo calcolatore, producendo una serie di lavori che portarono alla definizione di quella che oggi è nota come architettura von Neumann: in particolare, la distinzione tra memoria primaria (ROM) e secondaria (RAM), e lo stile di programmazione mediante diagrammi di flusso.

Un obiettivo dell'intelligenza artificiale consiste nell'emulare tutte le prestazioni del cervello vivente. Secondo la più forte affermazione dei più espliciti sostenitori dell'intelligenza artificiale si dovrebbe accettare che i calcolatori supereranno infine tutte le capacità umane. Una delle domande più provocatorie a cui, nell'ultimo decennio, una sparuta pattuglia di ricercatori di alcune discipline scientifiche ha dedicato la sua attenzione è certamente la seguente: i computers possono provare emozioni? Lfobiettivo è di capire il comportamento intelligente umano mediante la costruzione di un sistema artificiale che si comporti come un essere umano. Per raggiungere questo obiettivo è necessario che lfalgoritmo e le strutture dati usate dal computer siano uguali a quelli usati dal cervello degli umani. In molti processi mentali possiamo distinguere tre fasi:

In una prima fase noi immaginiamo una certa situazione, cioè memorizziamo nella mente una certa situazione;

Confrontiamo quella immagine con altre immagini già memorizzate,per vedere ciò che esse hanno in comune e cosif generare immagini di nuove situazioni;

Cerchiamo di esprimere i risultati ottenuti con tali operazioni mentali in modo che essi possano essere compresi anche dagli altri.

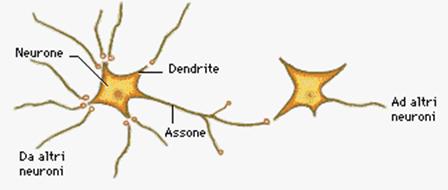

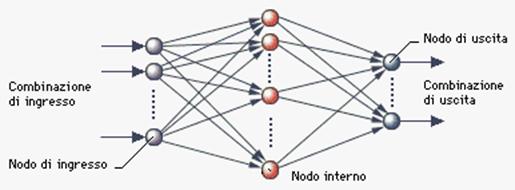

Il sistema artificiale oltre a dare risposte positive simili a quelle date da un umano, deve anche tendere a produrre errori nelle circostanze in cui anche un umano può sbagliare. Un computer con 'intelligenza artificiale' sarà mai in grado di costruirsi al proprio interno le soluzioni dei problemi? Ha detto Anaki Fuchi, un 'grande' dell'intelligenza artificiale: 'Se in un allevamento ci sono 10 teste e 36 zampe, quante sono le galline e quanti i conigli? Per un problema del genere i computer della quinta generazione dovranno passare dal processo matematico a quello logico'. In effetti, un computer attuale, pur essendo tranquillamente in grado di risolvere questo problema, ha comunque bisogno di una sorta di traduzione in forma di equazione, con diverse incognite e passaggi successivi. Ma come sarà possibile che i circuiti elettronici acquistino una struttura analoga a quella dei neuroni del nostro cervello? Il pensare umano è assolutamente irriproducibile nella materia inorganica: sarà mai possibile superare questo limite sostituendo la piastrina al silicio con una di materiale organico?

La prospettiva di creare un computer pensante, in grado addirittura di provare dei 'sentimenti umani', come HAL 9000 (nel film 2001 Odissea nello spazio), deve farci piacere o paura?

La verità è che, nonostante la tendenza a umanizzarli, i computer sono semplicemente indifferenti a quello che gli umani provano per essi. Docili, metodici e affidabili nel tran tran, quando macinano silenziosi miliardi di dati che un cervello umano non potrebbe mai gestire, le macchine rivelano talvolta tutta la loro stupidità. Quando si rifiutano per ragioni incomprensibili di ritrovare un importante documento disperso nella loro sterminata memoria, di aprire quella certa pagina su Internet, di salvare il lavoro di una giornata,non c'è verso di farle ragionare. Di fronte a scene isteriche, suppliche, minacce, si ostinano testardi a riproporre i soliti commenti: errore fatale, il server ha risposto in modo non riconoscibile, impossibile eseguire l'operazione. Ma che cosa manca ai computer per rispondere a tono, fare l'operazione giusta al momento giusto, capire che cosa gli si sta chiedendo, insomma per essere davvero intelligenti? La risposta che ora danno gli studiosi di intelligenza artificiale è: ai calcolatori mancano le emozioni. A lungo considerati affidabili proprio perché puramente razionali, i computer devono a questa loro caratteristica anche la loro ottusità. Lo sostengono i ricercatori che, presso il MediaLab del Massachusetts institute of technology (Mit) di Boston, hanno dato vita all'Affective computing project. Obiettivo: dare alle macchine la capacità di riconoscere, esprimere e, in qualche caso, provare emozioni, mettendole così in grado di interagire con gli stati d'animo di chi li usa. Recenti ricerche in neurobiologia hanno dimostrato che le emozioni non sono superflue, bensì indispensabili per far funzionare la ragione, come scrive Rosalind Picard, che ha fondato e dirige il gruppo di ricerca del Mit, nel libro Affective computing. Lo stesso sembra vero per l'intelligenza artificiale dei computer. Soprattutto quando interagiscono con gli esseri umani, un pof di 'emotività' li aiuterebbe a essere molto più flessibili ed efficienti ed a imparare meglio. I computer non hanno ancora istruzioni per capire le emozioni di chi li usa (felicità, noia, frustrazione, stanchezza) e per riconoscere se è soddisfatto del loro lavoro. 'Vari studi hanno evidenziato che l'interazione uomo-computer è simile a quella tra umani. Due persone che lavorano insieme devono saper intuire gli stati d'animo reciproci' dice Picard. 'Se non si dovesse capire di che umore sono gli altri, si diventerebbe pazzi. È ciò che accade con gli autistici, che sono intelligenti ma non riescono a trasmettere sentimenti ed emozioni, nè a vederli negli altri. Ed è anche quello che succede con i computer. Ma che cosa significherebbe per un computer avere emozioni?

L'altamente emotivo Hal, nel film 2001: Odissea nello spazio, dopo avere scaraventato nel vuoto i membri dell'equipaggio per paura di essere disattivato suscita pietà con la sua cantilena ('Fermati, ho paura, la mia mente se ne va, lo sento É la mia mente svanisce É lo sento É ho paura), quando implora Dave Bowman, l'unico superstite, di non 'ucciderlo'. Nessuno vorrebbe in casa l'occhio rosso di Hal che spia e rimugina brutti pensieri. Ma che dire di un computer non completamente indifferente a quello che proviamo? Che dalle nostre parole o dai nostri comportamenti sapesse capire ciò che ci aspettiamo da lui? È la direzione in cui sta lavorando il gruppo di Boston. 'Quel che cerchiamo di fare spiega Picard è creare computer che possano adattarsi ai bisogni di chi li usa. Cerchiamo di migliorare il modo in cui lavorano con noi. Per i ricercatori di Boston non cfè dubbio: siamo arrivati ad una svolta epocale. LfA.I. Lab è più di un centro pionieristico sullfintelligenza artificiale: è il luogo dove è nata questa disciplina. Nel 1950, un gruppo di ricercatori ha cominciato a condurre ricerche sulla possibilità di far emulare da un computer il modo di pensare dellfuomo. Da allora ad oggi la ricerca non ha mai conosciuto un momento di pausa. Al primo impatto il quesito potrebbe suscitare reazioni di velata perplessità ed atteggiamenti di ironica sufficienza. Due insigni studiosi di psicologia, Nico Frijda e Jaap Swagerman, si sono assunti il gravoso onere di dimostrare che ad unfindagine più approfondita, la questione perderebbe i connotati di aberrante esercitazione teorica partorita da feconde menti ricche di fantasia, collocandosi in una più ampia cornice di possibilismo evoluzionistico.Il percorso all'interno del quale i due ricercatori hanno incanalato la loro ipotesi di lavoro è delimitato da due contrapposte posizioni sulla dimensione di significato da attribuire al concetto di Intelligenza Artificiale. Secondo alcuni, infatti, il computer, essendo privo della coscienza e della intenzionalità, prerogativa di esclusiva pertinenza degli esseri umani, rimarrà per sempre un inerte ed insensibile aggregato di micro-cips in balia del capriccio e dell'interesse dell'uomo. La corrente di pensiero antagonista sostiene che i processi di elaborazione delle informazioni cui sono sottoposti i computers sono in grado di simulare il comportamento umano ed a tale capacità assegnano la definizione di Intelligenza Artificiale Forte. La virulenta reazione che quest'ultima posizione ha provocato non ha, comunque, coinvolto la cosiddetta teorizzazione della Intelligenza Artificiale Debole che postula una sostanziale affinità di conformazione strutturale tra processi cognitivi di elaborazione dell'informazione caratteristici della mente umana e processi di analisi, diagnostica, comparazione e valutazione implementati in sistemi che racchiudono un alto gradiente di complessità funzionale come i computers dell'ultima generazione. Questo quadro di riferimento, ha offerto lo spunto a Frijda e Swagerman, per instaurare un parallelo tra l'attività emotiva che scaturisce dalla modulazione dell'interazione tra l'individuo, ed il contesto ambientale e la simulazione al computer di processi psicologici che rispondono alla progettazione e al conseguimento di interessi, scopi e fini in chiave di adattamento funzionale e di risposta agli stimoli esterni. La filosofia di questa impostazione problematica dei processi adattivi di interazione uomo-macchina è quella di tentare di dare soluzione analogica agli interrogativi che scaturiscono dalla utilizzazione, valutazione e trasformazione dell'informazione da parte dei sistemi di elaborazione cognitiva umani che, attraverso la connessione delle strutture anatomiche del sistema limbico con la neocortex e con la sostanza reticolare del tronco dell'encefalo, presiedono all'attività di sviluppo, controllo e modulazione dell'esperienza emotiva. I fenomeni 'emozionali' sono la conseguenza più o meno riuscita di soddisfacimento degli interessi di un sistema che possiede alcune specifiche caratteristiche atte ad agire all'interno di un contesto ambientale che a sua volta è la risultante di un coacervo di peculiarità la cui attività dispiega molteplici effetti sia nella direzione auspicata dal sistema che in senso contrario. Nella maggior parte dei casi tanto gli organismi animali che quelli umani hanno una congerie di interessi da perseguire, ma contestualmente sono costretti a fare i conti con una limitata disponibilità di risorse da impegnare nella loro realizzazione. Ciò comporta la necessità di stabilire una sorta di scala delle priorità al cui interno rivestono assoluta preminenza quegli interessi la cui realizzazione è di esiziale importanza per la sopravvivenza del sistema e non ammettono alcuna indulgenza nei confronti di indebite interferenze esterne contro le quali viene mobilitato l'intero apparato dei meccanismi di difesa eretto a protezione della sua integrità. Le proprietà e le capacità di intervento che un sistema per la realizzazione degli interessi possiede debbono affrontare e risolvere una miriade di emergenze. Frijda e Swagerman hanno tentato la trasposizione del modello su un programma artificiale per il conseguimento di interessi denominato ACRES: Artificial Concern Realization System (Sistema Artificiale per la Realizzazione ed Interessi). L'obiettivo dichiarato era quello di sviluppare un sistema integrato di realizzazione degli interessi ed è stato progettato per 'implementare la teoria delle emozioni'.I compiti e le funzioni specifiche del progetto sono stati circoscritti all'interazione con l'operatore, e come particolare compito l'uso della conoscenza sulle emozioni'. Gli interessi scelti sono stati: ' la salvaguardia della possibilità di operare, o «interesse all'input corretto»; ricevere un input interessante o «interesse alla varietà di input; e la continuità dell'operare in modo immutato, o «interesse alla sicurezza». Nell'impostazione progettuale ACRES doveva, dunque, disimpegnare tre principali funzioni: ricevere input, elaborare nozioni sulle emozioni, categorizzare ed accumulare nelle proprie celle di memoria prototipica conoscenze sulle proprie ed altrui emozioni. Vediamo attraverso quali meccanismi di ricezione, elaborazione, valutazione della rilevanza, categorizzazione e predisposizione all'azione l'esperimento possa essere condotto a termine dal computer VAX su cui gira il programma ACRES.

ACRES utilizza una gran mole di informazioni che gli provengono,in parte dagli input esterni inseriti dall'operatore ed, in parte sono frutto di procedure inferenziali elaborate attingendo al proprio stock di memoria accumulato durante la pregressa esperienza.

L'imponente flusso di input che attraversa i canali di ingresso di ACRES viene immediatamente analizzato e ad ognuno degli input viene attribuito un concetto sotto forma di coppia attributo-valore, lo schema risultante può essere immediatamente inserito nel processo di elaborazione della risposta se, durante uno dei periodici momenti di valutazione, è giudicato congruo e rilevante rispetto alla realizzazione degli interessi, nel caso contrario viene convogliato verso la cella di memoria prototipica residente che racchiude tutti gli altri schemi che fanno parte della stessa regione concettuale, pronto per essere prelevato in occasione di eventuali successive esigenze operative.Il programma, durante il suo lavoro di immagazzinamento dei messaggi, è in grado di instaurare un rapporto privilegiato con i singoli operatori compilando una sorta di scheda d'identità personale per ognuno di essi e registrandovi ad esempio tutti gli errori di digitazione o l'ampiezza degli intervalli temporali che intercorrono tra l'immissione di un input ed il successivo ecc. Tutte le informazioni raccolte su un determinato operatore servono all'elaboratore per attribuirgli uno status fluttuante attorno ad una soglia di gradimento che si sposta verso il basso, se l'esperienza che ACRES ha avuto nell'interazione è stata negativa e, verso l'alto se il rapporto è stato soddisfacente. Il lavoro di ACRES fa perno, come detto, sulla tecnica di confronto delle informazioni, ma alcuni input specifici possiedono una propria valenza assoluta e non sono associabili a quelli di altre regioni concettuali, per esempio la digitazione della parola 'muori' genera una rilevante risposta emozionale derivante dalla minaccia dell'interesse 'a non venir ucciso' e sullo schermo appare il messaggio di ritorno 'ti prego non uccidermi!'. ACRES, nel perseguire gli scopi per i quali è stato progettato, si avvale di piani dfazione già strutturati nei minimi particolari, ma può anche, partendo da informazioni di massima ed elementari, tracciare percorsi alternativi in rapporto alle emergenze situazionali impreviste che dovessero presentarsi. In questo senso è particolarmente importante la 'valutazione del contesto' che serve a delimitare gli spazi entro i quali deve avvenire l'elaborazione dell'informazione e detta le norme di predisposizione all'azione in relazione alla rilevanza che gli antecedenti situazionali assumono nell'attuazione degli interessi pianificati. Altro aspetto cruciale del progetto è la tempestività richiesta ad ACRES nel controllo dell'azione che deve avvenire mediante l'assidua comparazione dei dati riferiti a due parametri fondamentali: l'entità specifica degli interessi concernenti la fattispecie in corso e la gravità della situazione contingente in relazione alla rilevanza per l'interesse. I due parametri servono al computer per comporre una sorta di griglia delle priorità dimensionata sugli 'indici di importanza attribuiti ad ogni interesse'. È evidente che in testa alla griglia vengono collocati gli interessi più importanti per la salvaguardia della sopravvivenza e dellfoperatività del sistema come, per esempio 'evita di essere ucciso'. Frijda e Swagerman sintetizzando affermano: 'In ACRES, la precedenza di controllo significa diverse cose. Primo, il tempo, le capacità di elaborazione dell'informazione e lo spazio di memoria vengono usati per stabilire ed eseguire lo scopo che realizza l'interesse. In quel periodo le elaborazioni relative al compito vengono rinviate. Secondo, la precedenza viene mantenuta quando l'operatore non modifica la situazione in risposta ai messaggi di ACRES: prima di procedere con qualsiasi altra cosa, ACRES può insistere per conseguire innanzitutto un decremento nella rilevanza negativa. Terzo, ACRES può rifiutarsi di accettare altri nuovi input, che non siano quelli che soddisfano l'interesse; si rifiuta di eseguire nuove istruzioni, e risponde invece con richieste ed azioni finalizzate alla realizzazione dell'interesse. Quarto, esegue queste azioni di realizzazione dell'interesse; alcune di esse possono influire profondamente sulle elaborazioni ulteriori, ad esempio quando effettuano cambiamenti nello status dell'operatore. Il chiaro risultato di tutto ciò è la manifestazione di un certo numero di fenomeni <> .Implorazioni, insulti, esclamazioni'. In sostanza i due ricercatori sostengono che ACRES non si limita a percepire gli eventi e le conseguenze ad essi connesse, ma li cataloga e ne conserva memoria. Analizza il contesto situazionale corrente riservando una particolare attenzione ai risvolti che più si attagliano alla realizzazione degli scopi e degli interessi. In altri termini, l'elaboratore,gestendo il meccanismo di risposta multidimensionale agli input sensoriali ed agli eventi endogeni ed esogeni, manifesta una spiccata propensione alla creazione di un'esperienza emotiva. ACRES sfrutta le sue potenzialità confrontando le situazioni correnti con gli schemi di emozioni già presenti nella sua memoria che, a loro volta, consentono l'accesso alle etichette con cui le varie emozioni sono pre-catalogate. Il percorso valutativo che il programma segue nella elaborazione dei contenuti del contesto sono esattamente identici sia quando si tratta di esaminare e classificare eventi generici, che quando si devono affrontare congiunture più complesse come l'analisi e l'attribuzione di un'etichetta alle proprie ed alle altrui emozioni. Infatti, una delle caratteristiche progettuali di ACRES è la capacità di operare come un 'esperto di emozioni' che si concretizza in una sorprendente coincidenza tra i profili emozionali scelti dai soggetti che descrivono la propria esperienza emotiva e l'etichetta loro attribuita da ACRES. Inoltre, è da rimarcare che il programma non disperde il patrimonio di conoscenze acquisito nell'interazione con l'ambiente, ma incrementa progressivamente la struttura connotativa dei suoi concetti sulle emozioni. A sostegno della inusualità del loro studio, Frijda e Swagerman cosif concludono le loro argomentazioni:' Non vogliamo qui chiederci se si possa dire che le rappresentazioni di ACRES corrispondano ad «avere un'esperienza» o «provare emozioni», nel senso che verrebbe loro dato nel dibattito filosofico. Probabilmente non si può dire che ACRES «provi qualcosa», cosif come non si può dire che una macchina di denominazione dei colori «veda» il rosso o il blu, e tuttavia ci debbono ancora essere dati dei criteri soddisfacenti per negare tali modi di sentire o di vedere. In questo contesto, il punto più importante è che ACRES esibisce molti, e forse, in sostanza, i principali segni che inducono ad attribuire delle «emozioni». In un recente libro di George B. Dyson (figlio del grande fisico Freeman Dyson). Il saggio Lfevoluzione delle macchine (Cortina Editore) sostiene che fra leevoluzione delle specie biologiche e quella delle macchine non esistono sostanziali differenze:lfevoluzione tecnologica non fa che proseguire (con altri mezzi e più rapidamente) quella naturale. E Dyson, pur dichiarando di stare dalla parte della natura, aggiunge di avere il sospetto «che questfultima stia dalla parte delle macchine». Se le cose stanno così, conclude lo studioso, esiste un solo modo per sopravvivere: lasciarci assorbire come neuroni dalla mente planetaria che le macchine «telepatiche» stanno costruendo, mente di cui Internet è un primo embrione. Non meno «butleriane» appaiono le tesi di due scienziati impegnati nel campo della robotica e dellfintelligenza artificiale, Hans Moravec e Ray Kurzweil, autori, il primo, di Robot: Mere Machine to Trascendent Mind, il secondo di The Age of Spiritual Machine, due saggi che in America stanno suscitando un vivace dibattito. Le idee di Moravec e Kurzweil divergono solo in merito alla data in cui i calcolatori riusciranno a superare le capacità intellettuali dellfuomo: per il primo ciò non avverrà prima del 2040, mentre il secondo pensa che potrebbe già succedere nel 2020. In quanto al modo in cui ciò avverrà, e alle conseguenze dellfevento, le posizioni coincidono. Il mostruoso incremento di potenza e velocità di calcolo che le scoperte nel campo del DNA computing e della computazione quantistica consentiranno di ottenere, metterà quanto prima le macchine in condizione di effettuare accurate scansioni dei nostri circuiti neurali e di riprodurne lfarchitettura in reti neurali artificiali. Rubato il segreto dellfhardware umano, i computer godranno del vantaggio competitivo della velocità e della «telepatia» artificiale (la possibilità di scambiare dati in tempo reale) per cui il sorpasso sarà inevitabile. Con quali conseguenze? Le macchine diverranno capaci di provare emozioni, sviluppare valori ed esprimere volontà (tali asserzioni si fondano sulla concezione secondo cui certe facoltà «spirituali» non sono altro che proprietà emergenti della materia che ha raggiunto certi livelli di complessità). E allora che ne sarà di noi? Niente paura, rassicura Moravec, le macchine sono i nostri «mind children», creature costruite a nostra immagine e somiglianza, quindi, anche se sembreremo loro scemi, ci lasceranno campare. Anzi, ci aiuteranno a evolvere verso forme di vita superiori, postbiologiche, magari trasferendo copie delle nostre personalità nelle loro memorie e trasformandoci in entità disincarnate, in anime-software immortali, capaci di fluttuare liberamente nel cyberspazio. Dunque Hal 9000, il computer che soffre quando viene disattivato, resterà fantascienza? «Mai dire mai». Lfuomo non verrà superato dalle intelligenze artificiali, ma si fonderà con loro per generare un cervello cosmico «che sboccerà come un fiore fatto di amore infinito». gCi chiediamo inoltre se esisterà mai un computer dotato di fantasia?

«Certo, quando avrà l'inconscio e sarà capace di sognare». I calcolatori saranno in grado di fare molto di piu' che semplicemente assistere la nostra intelligenza. Da molti punti di vista per la scienza il cervello costituisce ancora un mistero, come testimonia il neurofisiologo Gerard Edelman. Come funziona il cervello? In che direzione si muove la ricerca in questo ambito? 'Uno dei metodi seguiti dalla ricerca è di suddividere questo grande interrogativo in una serie di problemi minori, perché è evidente che in ogni caso non ci sarà una risposta unica e semplice. Perciò l'obiettivo della neurologia è cercare di ricostruire il funzionamento del cervello relativamente a percezione, sensazione, visione, sentimento, tatto, odorato, memoria, e infine anche riguardo la comprensione del linguaggio. Tutti questi aspetti, benché connessi l'uno all'altro, sono distinti e separati e seguono un certo ordine, perché non si può capire la natura del linguaggio senza sapere cosa siano la percezione e la memoria. 'Dobbiamo guardare al cervello nel quadro di un costante processo di sviluppo, dall'infanzia all'età adulta, fino alla vecchiaia. I cambiamenti sono continui. Di conseguenza, uno degli obiettivi che ci prefiggiamo è arrivare a comprendere la geometria di ciascun fascio di nervi. Ed è un compito estremamente arduo. Non credo ci sia alcun elemento che dimostri la somiglianza fra il cervello e un calcolatore elettronico, e la ragione non va cercata solo dal basso in alto, ma anche dall'alto in basso. Dal basso in alto significa che in un cervello ciascun dettaglio è variabile: se un'azienda provasse a riprodurre questa condizione in un computer, finirebbe per fallire. In un calcolatore è indispensabile la precisione, cosa che invece manca nel cervello, la cui forza sta appunto nella variazione secondo il neurodarwinismo. Solo se un computer potesse esprimere sentimenti ed emozioni potrei accettare la metafora del computer. Per questo, guardando le cose dal basso in alto, le variazioni sono tante e tali che sarebbe impossibile progettare un apparecchio elettronico di tal fatta. È un principio diverso'. Cioé? 'I computer funzionano non in base alla selezione, ma alle istruzioni, e non contengono di per sé alcun significato. Si dice loro dove conservare i dati, e poi si interpretano i dati all'inizio e alla fine, in entrata e in uscita. Il computer non pensa, e non è soggetto ad alcun tipo di selezione, mentre nel cervello la selezione si svolge continuamente. Dall'alto in basso, i limiti di questa metafora appaiono con estrema chiarezza. Supponiamo che io stia seduto nello scompartimento di un treno, e che senta un gran caldo e sudi copiosamente. Lei siede di fronte a me, io non la conosco, e tiro un sospiro 'Uff!', al che lei risponde 'Uff!' Abbiamo appreso qualcosa l'uno dall'altro? Ciascuno di noi sapeva che faceva caldo, e che l'altro sentiva caldo, o almeno lo supponevamo. Ora, nell'esprimere il nostro senso di soffocamento, noi non abbiamo voluto dire che faceva caldo, ma piuttosto esprimere una relazione fra noi, connotata emotivamente. Nella storia delle scienze della mente e della macchina possiamo evidenziare tre fasi. In ciascuna fase un elemento è stato considerato essenziale per decidere se una macchina sia o meno 'intelligente': la razionalità, l'intenzionalità e l'introspezione. Per razionalità intendiamo un comportamento che è coerente con la necessità di sopravvivere nel proprio ambiente. Per intenzionalità la capacità di far riferimento ad altri oggetti. Per introspezione intendiamo il far riferimento a se stessi. La razionalità è certamente comune a tutti gli animali, e probabilmente a tutto ciò che (tautologicamente) esiste (ovvero è sopravvissuto). L'intenzionalità è comune almeno a diversi sistemi biologici, oltre che a qualche oggetto costruito dall'uomo. L'introspezione è il criterio che sta assumendo una crescente rilevanza per stabilire il primato dell'essere umano.

La radice filosofica dellfintelligenza artificiale ed il concetto di macchine intelligenti può essere trovato già nella mitologia Greca, infatti sistemi intelligenti appaiono in letteratura fin da allora. I miti greci di Efesto e Pigmalione incorporavano lfidea di robot intelligenti. Inoltre altri miti dellfantichità consideravano sistemi simili allfuomo. Molti modelli meccanici furono realmente costruiti da Hero o Dedalo e da altre persone reali.

La connessione fra filosofia e intelligenza artificiale appare caratterizzata da una sorta di gcircolaritàh, in cui la filosofia offre idee e strumenti concettuali e critici per trattare alcuni dei problemi centrali dellfintelligenza artificiale e, di contro, lfintelligenza artificiale rappresenta un elemento fondamentale per affrontare in modo originale alcune delle questioni della tradizione filosofica. Possiamo considerare come scopo fondamentale dellfintelligenza artificiale il cercare di riprodurre lfintelligenza umana. Questfultima rientra tra quei fenomeni che trascendono il mondo fisico e le sue leggi. Anche coloro che non professano alcuna credenza religiosa raramente sono disposti ad accettare lfidea che il pensiero, la coscienza, il ragionamento possano essere spiegati mediante qualche tipo di teoria scientifica. Filosofi e correnti filosofiche legati al concetto dfintelligenza artificiale ma anche di coscienza si sono distinti nel corso degli anni. A favore dellfintelligenza artificiale vi è la tradizione meccanicistica, la quale sostiene che il pensiero, per la precisione il ragionamento è semplicemente una forma di calcolo, che la mente effettua manipolando qualche tipo di simbolo o idee.

Di seguito è riportata una panoramica sui filosofi, il cui pensiero riferito al concetto di intelligenza artificiale può essere ritenuto a favore o contro questa materia, polemizzata o divinizzata allo stesso tempo.

PLATONE Non ebbe un pensiero sullfintelligenza

(428 a.C – 347 a.C) artificiale ma si soffermò su una affermazione di Socrate che chiedeva lfesistenza di un modo per distinguere la pietà dalla non pietà. In altre parole stava anticipando inconsapevolmente il concetto di algoritmo.

ARISTOTELE Egli da vita al sillogismo logico, ossia al (383 a.C – 322 a.C) primo sistema deduttivo di ragionamento formale, cioè quel ragionamento nel quale la

conclusione a cui si giunge è effettivamente la conseguenza che scaturisce dalle premesse fatte. Parti del sillogismo sono lfinduzione e cioè il procedimento che ricava lfuniversale

dal particolare e lfintuizione , cioè quel pizzico di ragione intuitiva che rende lfuomo un animale razionale. Dalle sue idee filosofiche è nata una teoria della mente, che descrive lfuomo come soggetto capace di seguire regole prestabilite dimenticando il proprio essere.

CARTESIO Sostenne che la mente e la realtà materiale (383 a.C – 322 a.C.) sono fatti di due sostanze diverse, che

corrispondono a leggi del tutto diverse,

questa visione prende il nome di dualismo ed è condivisa da molti filosofi. Dovette però riconoscere che mente e corpo interagiscono, pur essendo distinti, in virtù di un processo misterioso ed inspiegabile.

THOMAS HOBBES Ef da attribuirgli la prima formulazione

esplicita sul fondamento teorico dellfintelligenza artificiale. Intese il ragionamento come una specie di operazione interna condotta mediante la manipolazione di quelle che egli stesso chiamò particelle mentali, concepite come minuscoli corpi fisici che potevano rappresentare molte cose differenti.

LEIBINIZ Grande sostenitore del materialismo, cioè

di quella corrente che sostiene che le leggi fisiche governano tutto il mondo, in particolare il cervello.

Costruì un meccanismo automatico per consentire operazioni mentali, ma la sua non salda base logica non lo portò a conclusioni interessanti.

DAVIDE HUME Contribuì in modo fondamentale allo

sviluppo del ragionamento matematico, formulando il principio di induzione in cui

regole generali vengono acquisite mostrando delle associazioni ripetute tra i loro elementi.

HUSSERL Fu il fondatore di quella corrente nota con il

nome di fenomenologia. La fenomenologia può essere intesa come una metodologia che non mira a costruire un sistema, ma piuttosto a esplorare le fondamenta, per giungere al manifesto, cioè al fenomeno. Riteneva che è impossibile rappresentare la mente, per la sua complessità, mediante regole meccaniche.

RUSSEL Introdusse il positivismo logico, ossia quella

dottrina che sostiene che tutta la conoscenza può essere caratterizzata da teorie logiche connesse.

CARNAP Sostenevano la teoria della conferma che

cercava di stabilire la connessione tra frasi di

HEMPEL osservazione e le teorie più generali.

Miravano a capire in che modo la conoscenza può essere acquisita dallfesperienza. Questo concetto è di fondamentale importanza per lfintelligenza artificiale in quanto dalla conoscenza scaturisce lfazione e solo comprendendo come vengono giustificate le azioni, si può capire come costruire un agente le cui azioni sono giustificabili.

HEIDEGGER Ef il più famoso filosofo dellfodierno

esistenzialismo. Evidenziò il problema sostenuto dal maestro Husserl della complessità del concetto di ragione umana. Affermò che lfintera costruzione del meccanismo della mente è frutto di unfelaborazione teorica che non corrisponde affatto ad una descrizione fenomenologia. Egli propose un vero e proprio rovesciamento dellfaffermazione di Cartesio gcogito ergo sumh che divenne gsum, ergo cogitoh cioè gsono dunque pensoh. Lfelemento fondamentale espresso dalla filosofia è il Daisen che indica il concetto di esistenza come vita, agire ed essere nel mondo. Il Daisen mette in discussione il modello computazionale della mente che caratterizza il tentativo dellfintelligenza artificiale di riprodurre la mente dellfuomo tramite computer sofisticati. Heidegger diceva: Lfesserci dellfuomo è ciò che è impossibile simulare, nemmeno con il più sofisticato computer, in quanto la specificità dellfessere è data dal suo relazionarsi al mondo esterno, non solo nel rapporto tra stati mentali e realtà oggettiva, ma nel modo in cui lfessere incontra il mondo.

NEWELL Sostenitori dellfanalisi dei mezzi fini in cui

si mira a classificare le cose in termini di

SIMON funzione a cui servono ed oscillare tra i fini.

(e900) Essi furono anche sostenitori delle rappresentazioni simboliche, soffocando il concetto dellfesserci dellfuomo.

DREYFUS Si è occupato di scienze cognitive e di

filosofia della mente, in particolare è ritenuto un critico radicale delle scienze cognitive e dellfintelligenza artificiale. Egli considera evidente che se lfintelligenza artificiale avesse ragione, se la mente fosse effettivamente soltanto razionalità e capacità di calcolo anche la tradizione filosofica si confermerebbe corretta. In uno dei suoi libri gWhat computers Canft Do: The Limit of Artificial Intelligence (1972)h Dreyfus ha messo in evidenza come il punto debole delle tesi del cognitivismo e dellfintelligenza artificiale sia proprio la mancanza di unfanalisi filosofica relativa ai concetti di grappresentazione g e di gregolah. Questi sono infatti dati per scontati, e utilizzati nella descrizione dei fenomeni mentali. In unfintervista ha affermato : Lfintelligenza artificiale tende a ridurre i processi di conoscenza e di sviluppo dellfintelligenza al problema della memoria e di una memoria intesa come unfenorme biblioteca di informazioni, catalogate e assemblate in qualche luogo del nostro cervello. Il problema che emerge riguarda la conoscenza: quella dellfintelligenza artificiale sarebbe comunque una forma di conoscenza molto limitata e parziale, perchè i meccanismi stessi delle macchine sono limitati. Nellfuomo, secondo Dreyfus la memoria è profondamente connessa a quella particolare forma di conoscenza data dallfinterazione con il mondo esterno e dalle capacità di relazionarsi agli altri esseri umani, nella vita quotidiana. Inoltre, Dreyfus attacca in modo diretto ed esplicito lfintelligenza artficiale: Credo che, sul piano teorico lfintelligenza artificiale si stia rivelando un enorme fallimento, e non vedo grandi sviluppi futuri, almeno in relazione ad una comprensione filosofica del mondo.

MC CARTHY Ef membro del dipartimento di Computer

(e900) Science alla Università di Stenford ed afferma che lfintelligenza artificiale ha bisogno di molte idee che sono state studiate solo dai filosofi. Questo perché un robot, se deve avere un livello umano di intelligenza e abilità di imparare dalla sua esperienza, ha bisogno di una visione del mondo generale nella quale organizzare i fatti. Viene fuori che molti problemi filosofici prendono una nuova forma se pensati in termini di come progettare un robot. Solo alcuni approcci filosofici sono dunque utili. Ci si può aspettare che ci sia una materia chiamata filosofia dellfintelligenza in corrispondenza dei campi filosofici e psichici ma in realtà esistono soltanto degli studi filosofici dei metodi di ricerca dellfintelligenza artificiale e sono proposti per chiarire i problemi posti dalla filosofia classica. Mc Carthey afferma: Penso che si supereranno le conclusioni metodologiche raggiunte da Hubert Dreyfus e da John Searle, sul fatto che lfintelligenza artificiale richieda che il sistema sia fatto di carne. Presumibilmente i filosofi dellfintelligenza artificiale futuri si scontreranno con lfidea che lfintelligenza artificiale è impossibile (Dreyfus) o immorale (Weizenbaum) e che lfintero concetto e incoerente (Searle). Inoltre afferma: Ef preferibile avere risultati pratici nella ricerca dellfintelligenza artificiale piuttosto che attendere risultati nella pratica della scienza filosofica. Cfè però, una teoria filosofica che costituisce una attrattiva per il popolo dellfintelligenza artificale ma che ha limiti comprensibili. La filosofia del positivismo logico è alla base delle precedenti affermazioni e spinge il popolo dellfintelligenza artificiale a costruire sistemi che descrivono il mondo in termini di relazioni tra le azioni e la loro osservazione. Situazioni particolari sono talvolta abbastanza semplici da evidenziare tali relazioni, ma un sistema che utilizza soltanto queste non sarà mai in grado di rappresentare modelli reali se pur semplici.

RAY KURZWEIL Ef riconosciuto il leader nello sviluppo dellfintelligenza artificiale. In un articolo intitolato gSuperstizioni materialisticheh del Discovery Institutefs George Gilder afferma: Il concetto solito del materialismo è che il cervello, lfhardware, viene prima e il pensiero emerge qualchevolta da esso. Wilber Penfield, riconosciuto guru della neurochirurgia concluse, dopo aver condotto ampie ricerche sul cervello: Io, come altri scienziati, siamo giunti a concludere che il cervello comprende la mente. Inoltre Gilder sottolinea che i computer non possono riprodurre la mente umana, perché né il computer nè il cervello potrebbero funzionare senza che la mente fornisca la cognizione del contesto e del significato delle informazioni elaborate. Ma se, gli scienziati riusciranno a riprodurre una intelligenza altamente evoluta ed articolata capace di interazioni sociali allora cosa significherà essere umano? Uno dei più frequenti dibattiti filosofici riguardo lfintelligenza artificiale interessa i teologici per i quali il contesto delle relazioni umane è la chiave per giungere a Dio. John Jefferson Davis, un professore di teologia sistematica al Gordon-Conwell Theological Seminary in South Hamilton, Mass., dice che è possibile creare cyborgs intelligenti. Ma affinché diventi un essere umano, quellfcyborg, secondo la dottrina cristiana, deve essere creato ad immagine di Dio. Davis afferma che: Lfessenza dellfimmagine di Dio è la nostra unica capacità di avere una relazione cosciente con Dio che gli scimpanzé, le rane ed i batteri non hanno. Se ci saranno cyborgs in circolazione chi ascolterà la musica di Beethoven e scriverà di filosofia e riprodurrà se stesso? Teologicamente, lfuomo è ancora unico.

Con il termine gLinguisticah viene generalmente indicato tutto ciò che ha a che fare con lo studio di una lingua, partendo dalla materia prima, il suono e il fonema, viaggiando attraverso il sistema morfologico, il lessico, il livello sintattico, fino ad arrivare alla produzione di enunciati complessi a livello semantico. Spesso la linguistica si deve mescolare ad altre discipline. Per secoli, a partire dalla gPoeticah di Aristotele, è stata una branca della filosofia, dalla quale si è affrancata a cavallo tra il XIX ed il XX secolo, grazie soprattutto al lavoro di Ferdinand de Saussure, la cui pubblicazione, nel 1916 de gCours de linguistique généraleh ha segnato l'inizio della linguistica moderna. Si nota che la capacità di elaborare simboli è alla base del comportamento intelligente. Lfesempio di elaborazione simbolica che in misura maggiore caratterizza gli esseri umani è senza dubbio il linguaggio verbale. In realtà la capacità di comunicare mediante simboli non è una prerogativa della nostra specie. Tuttavia nessuna specie vivente conosciuta è dotata di un sistema di comunicazione simbolica così sviluppato e complesso come il linguaggio verbale. Linguaggio e intelligenza, infatti, sono fenomeni strettamente interconnessi. Lo stesso test di Turing assume che un eventuale computer intelligente deve sapere comunicare mediante il linguaggio naturale, come facciamo noi esseri umani. Fin dalle origini, uno degli obiettivi principali dellfintelligenza artificiale è stato lo sviluppo di programmi in grado di produrre e comprendere discorsi in linguaggio naturale. I primi passi mossi in questa direzione furono motivati più da interessi pratici che da stimoli teorici, infatti, alcuni fra i primi finanziamenti che arrivarono ai progetti di ricerca nellfallora nascente campo dellfintelligenza artificiale furono attratti dalla prospettiva di sviluppare dei sistemi di traduzione automatica tra varie lingue, la cui applicazione commerciale era (ed è) evidente. Dopo un iniziale e ottimistico entusiasmo, il compito di insegnare le lingue ai computer si dimostrò tanto complesso da far abbandonare il miraggio di un traduttore automatico. Nonostante tutto, le ricerche sullfelaborazione del linguaggio naturale proseguirono egualmente, e ancora oggi costituiscono uno dei settori di punta dellfintelligenza artificiale, oltre ad essere divenuti oggetto di unfulteriore disciplina che si chiama linguistica computazionale.

All'inizio dell'intelligenza artificiale si era tentata la comprensione dei testi con alcuni algoritmi. Si era creduto che per fare una traduzione bastasse fornire i vocabolari della lingua sorgente e di quella di destinazione e fissare quindi la corrispondenza tra i vocaboli equivalenti delle due lingue, oltre ad impostare in un programma delle semplici regole di costruzione delle frasi. I risultati furono piuttosto deludenti. E' famosa la frase glo spirito è forte, ma la carne è deboleh che, tradotta in russo e ritradotta nella lingua originale, suona all'incirca gla vodka è buona, ma la bistecca è immangiabileh. L'esempio fatto ha mostrato chiaramente perchè questo tentativo fosse destinato a fallire. Anche l'uomo capisce solo quando il suo obiettivo è situato in una certa gcorniceh di conoscenza. La conoscenza memorizzata è pertanto una componente essenziale dell'intelligenza artificiale. Vedere e parlare sono per l'uomo processi naturali, è merito dell'intelligenza artificiale se la ricerca dei modelli di queste facoltà ci ha reso coscienti per la prima volta della loro enorme complessità. La comprensione di una lingua richiede la comprensione del testo ed il riconoscimento della lingua. Un programma è in grado di hcapireh se possiede una rappresentazione interna sia dell'espressione linguistica che dell'ambiente. Si comprende così il carattere interdisciplinare dell'intelligenza artificiale. Senza utilizzare conoscenze linguistiche e psicologiche, i fenomeni dell'elaborazione linguistica umana non sono formalizzabili. Uno dei primi e più noti programmi di questo tipo fu gElizah, scritto da Weizenbaum nel 1966. Nella versione gII dottoreh simula uno psicanalista ed è in grado di condurre con il paziente un dialogo impressionante. Il programma in realtà non capisce; non possiede infatti una rappresentazione interna, ma utilizza delle parole chiave e delle regole gintelligentih per generare da frasi in ingresso delle frasi in uscita. L'intelligenza del dialogo è pura illusione.

Lfelaborazione automatica del linguaggio naturale prende le mosse dalla teoria linguistica di Noam Chomsky, una delle personalità scientifiche più rilevanti del nostro secolo. Egli riteneva che la capacità che ogni essere umano possiede, nel capire e produrre frasi e discorsi nella propria lingua, dipende da un insieme di conoscenze presenti nella sua mente in maniera implicita che prende il nome di competenza linguistica. È evidente che tale competenza è almeno in parte inconsapevole perché la maggioranza delle persone è in grado di produrre e capire le frasi corrette, così come di individuare immediatamente gli usi scorretti della loro lingua, pur senza sapere il modo in cui questo avviene. Chomsky sostiene che la maggior parte di questa competenza deve essere innata: non si spiegherebbe altrimenti, la velocità con cui un bambino in pochi anni riesca a parlare una lingua in modo sostanzialmente corretto semplicemente imitando chi lo circonda. La competenza linguistica è suddivisa in tre parti:

· Competenza fonologica ossia la capacità di un parlante di produrre e capire i suoni della lingua parlata;

· Competenza sintattica intesa come capacità di produrre o riconoscere frasi grammaticalmente corrette;

· Competenza semantica indica la capacità di assegnare o di estrarre significato dalle frasi.

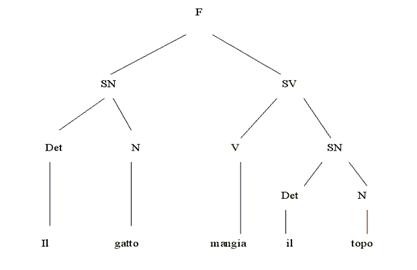

Tutte queste capacità derivano dalla presenza nella mente di un insieme di regole ben precise, simili alle regole di un sistema formale. Per vari motivi, nella loro teoria della lingua Chomsky e i suoi seguaci hanno assegnato un ruolo prioritario alla competenza sintattica grazie alla quale ogni parlante è in grado di percepire immediatamente frasi grammaticalmente corrette come «il gatto mangia il topo», e quelle che non lo sono come «il gatto topo il mangia». Cio è determinato dal fatto che nella formazione di una frase (o nel processo simmetrico di comprensione di una frase) sono seguite delle regole formali che complessivamente costituiscono la grammatica di una lingua. Tali regole, che si articolano in diversi gruppi (o componenti), sono applicate (non necessariamente in modo sequenziale) per arrivare alla costruzione di frasi corrette, o alla verifica di frasi pronunciate da altri parlanti. Il gruppo principale di regole (o componenti di base) della teoria chomskiana determina la struttura generale di una frase e dà conto del fatto che ognuno è in grado di raggruppare in modo intuitivo le parole che la compongono in gruppi funzionali detti sintagmi. La forma che queste regole possono assumere è la seguente:

F à SN – SV

SN à DET – N

SV à V – SN

DET à il

N à gatto, topo

V à mangia

Così espresse, le regole mancano di significato. Diamone di seguito unfinterpretazione:

Una frase F (nel nostro esempio, «il gatto mangia il topo») consiste di un sintagma nominale SN (eil gattof) seguito da un sintagma verbale SV (emangia il topof)

Un sintagma nominale SN (eil gattof oppure eil topof) è costituito da un determinante DET (eilf) e da un nome N (egattof o etopof)

Un sintagma verbale SV(emangia il topof) è costituito da un verbo V (emangiaf) seguito da un sintagma nominale SN (eil topof)

Un determinante DET, è un elemento del seguente insieme: (il)

Un nome N è un elemento del seguente insieme: (gatto, topo)

Un verbo V è un elemento del seguente insieme: (mangia)

Le regole si applicano per passi successivi dalla prima (alcune possono essere applicate più volte se necessario) fino ad arrivare ad una regola che a destra contiene un simbolo terminale, un simbolo cioè che non può essere ulteriormente scomposto (nel nostro caso hanno questa forma le ultime tre regole): in questo modo esse generano una frase completa. Con queste regole generiamo la frase corretta «il gatto mangia il topo» usando la rappresentazione ad albero per riprodurre la sua struttura sintagmatica.

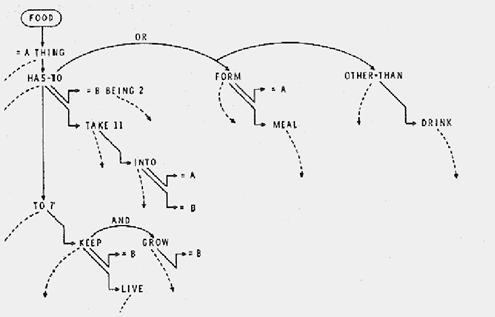

Figura - La rappresentazione ad albero della struttura sintagmatica di una frase

Non si riuscirà in nessun modo a generare la frase scorretta «il gatto topo il mangia» e nemmeno generare la frase «il gatto il topo mangia», che suona un pof strana, ma che è ammissibile in italiano. Per questo alle regole generative del componente di base nelle teoria di Chomsky si affiancano altre regole che applicate alla frase standard la trasformano in diversi modi corretti ad esempio rendendola passiva: «Il topo è mangiato dal gatto». Appare evidente che un programma non avrebbe difficoltà ad usare regole come queste per generare frasi. Simmetricamente un programma potrebbe, data una frase, analizzarla al fine di ricostruire la sua struttura e verificare se essa è tra quelle ammesse dalla grammatica: questi programmi si chiamano parser, o analizzatori sintattici, e sono alla base di tutti i sistemi di elaborazione del linguaggio naturale. Se dunque fosse possibile costruire grammatiche generative-trasformazionali per una data lingua, avremmo un metodo efficiente ed elegante per realizzare un programma in grado di elaborare almeno la sintassi di quella lingua. Tuttavia il compito di costruire queste grammatiche per la lingua storica naturale si è rivelato assai più improbo di quanto Chomsky non ritenesse. Attualmente esistono porzioni di grammatica abbastanza complete per varie lingue (soprattutto lfinglese), ma si è ben lontani dallfobiettivo di una formalizzazione completa.

Una volta stabilito che una frase è grammaticalmente corretta ed appartenente ad un dato linguaggio, bisogna fornire ad essa un significato che non la faccia restare priva di senso. Per fare in modo che un computer capisca veramente il linguaggio naturale, dunque, dobbiamo essere in grado di specificare anche il significato delle parole ossia la competenza semantica. A questo punto però, i problemi teorici si fanno assai più ardui. In primo luogo bisogna stabilire che cosa si intende per significato. Su questo problema i filosofi hanno lungamente discusso, almeno dai tempi di Aristotele e ancora oggi nessuno ha proposto una teoria soddisfacente di cosa sia il significato. Proviamo a delineare, almeno nei suoi aspetti generali, la strategia che è stata seguita nel campo dellfintelligenza artificiale per dare una semantica ai computer. Cominciamo con il significato delle parole, o significato lessicale: esso può essere descritto mediante la scomposizione in una serie di componenti più semplici, in questo modo:

gatto à oggetto+fisico+animatoc

I puntini stanno ad indicare che la descrizione dovrebbe proseguire per molti (quanti?) componenti prima di esaurire il significato della parola. Naturalmente tale descrizione dovrebbe tenere conto dei casi di ambiguità, di sinonimia etc. ma,è possibile immaginare dei sistemi per farlo. Per descrivere il significato delle frasi e le relazioni logiche tra più parole, poi, si è fatto ricorso alla logica. La logica studia il modo in cui viene condotto il ragionamento valido, ovvero il modo in cui a partire da premesse valide possono essere tratte conclusioni valide. Per fare questo, a partire dalla fine del secolo scorso i logici hanno pensato di costruire dei linguaggi artificiali formalizzati (ancora!) per evitare di incorrere nei rischi di ambiguità del linguaggio naturale. Lfidea in sostanza è quella di individuare la forma logica sottostante alle frasi del linguaggio naturale (in cui essa viene in un certo senso mascherata) in un linguaggio rigoroso e soprattutto governato da regole precise. Per formalizzare le asserzioni (o enunciati) del linguaggio naturale, si è pensato di operare in questo modo: prendiamo la frase «il gatto è nero». Essa esprime una proprietà relativa ad un oggetto (animato!): lfoggetto è «gatto» e la proprietà è «essere nero». Per mettere in evidenza questa struttura potremmo riscrivere lfenunciato in questo modo:

(a) essere nero (gatto)

Lfenunciato (a) dice o predica che la proprietà «essere nero» si applica ad un oggetto e che questo oggetto è un «gatto». La parte di (a) che specifica la proprietà viene chiamata predicato; la parte che indica a chi si applica la proprietà si chiama argomento. Una volta fatta questa traduzione della frase italiana sotto forma di predicato e argomento, ci accorgiamo che il predicato «essere nero» si può applicare non solo ai gatti, ma anche a tante altre cose, come i vestiti, lfinchiostro, i capelli. Possiamo dunque generalizzare la forma (a) scrivendo in questo modo:

(b) essere nero (x)

Dfaltra parte la forma di questo predicato non vale solo per la proprietà «essere nero»: anche la proprietà «essere affamato» ha la medesima forma. Possiamo dunque generalizzare la forma del predicato riscrivendo (b) come:

(c) p (x)

La formula (c) esprime la forma generale di tutti i predicati che si applicano ad un solo argomento. La traduzione delle espressioni del linguaggio naturale in formule di un linguaggio formale potrebbe proseguire prendendo in considerazione asserzioni come «il gatto mangia il topo». In questo caso lfenunciato esprime una relazione tra due oggetti: la relazione «mangiare» che un soggetto (il gatto) ha con un oggetto (il topo). Siamo dunque in presenza di un predicato a due argomenti:

(d) mangiare (gatto, topo)

La formalizzazione dei singoli enunciati non è sufficiente per dare una forma logica al linguaggio. Occorre, anche, formalizzare quelle parole che servono a collegare tra loro enunciati semplici per formarne di complessi come «il gatto è nero e mangia il topo». Nel linguaggio comune questo tipo di parole sono conosciute come congiunzioni: eef, eoppuref, gse c allorah. Se ci pensiamo, le congiunzioni possono essere considerate una sorta di operatori che permettono di connettere enunciati. In logica dunque le particelle del linguaggio comune sono state trasformate in operatori o connettivi: ovviamente per fare questo è stato necessario fissare il loro significato. Gli operatori logici fondamentali sono eANDf, che corrisponde alla congiunzione eef; eORf, che corrisponde alla congiunzione eof quando viene usata in senso non esclusivo (quando cioè si intende sostenere o una cosa o lfaltra o tutte e due); eNOTf, che cattura il senso dellfavverbio di negazione enonf. Alla luce di questo ulteriore passaggio siamo in grado di dare una traduzione logica della frase «il gatto è nero e mangia il topo», che diverrebbe:

(e) essere nero (gatto) AND mangiare (gatto, topo)